Utilizzare Microsoft Copilot senza il Cloud

Gli assistenti AI “Copilot” di Microsoft – da Microsoft 365 Copilot nelle applicazioni Office, a GitHub Copilot per la programmazione, fino al nuovo Windows Copilot – promettono tutti di aumentare la produttività grazie all'IA generativa. Tuttavia, oggi questi strumenti sono in gran parte basati sul cloud. Si affidano a modelli linguistici di grandi dimensioni, eseguiti nei data center di Microsoft, per generare risposte, suggerimenti di codice e approfondimenti. Questo solleva una domanda fondamentale per molti responsabili IT: È possibile utilizzare Copilot senza connessione Internet o dipendenza dal cloud?

In questa analisi approfondita esamineremo lo stato attuale della dipendenza dal cloud di Copilot, quali opzioni (se presenti) esistono per un utilizzo offline o on-premises e come Microsoft stia evolvendo Copilot per scenari ibridi. Esamineremo ciascuna offerta Copilot – Microsoft 365, GitHub e Windows – e discuteremo strategie aziendali per ambienti con connettività limitata. Evidenzieremo inoltre la roadmap di Microsoft e le soluzioni emergenti volte ad ampliare la disponibilità di Copilot oltre il cloud.

(Spoiler: Le esperienze Copilot di oggi sono per lo più legate al cloud, ma i cambiamenti sono all'orizzonte. Nel frattempo, esistono modi per ridurre i requisiti di cloud e prepararsi a implementazioni di IA più flessibili.)

La natura Cloud-Based di Microsoft Copilot oggi

Tutti i servizi Microsoft Copilot attuali funzionano principalmente come assistenti AI basati sul cloud, il che significa che eseguono l'elaborazione AI pesante su server remoti. Ricapitoliamo brevemente come funziona ciascun Copilot e perché è generalmente necessaria una connessione internet attiva:

- Microsoft 365 Copilot – Un assistente AI per Word, Excel, PowerPoint, Outlook, Teams, ecc., che utilizza OpenAI GPT-4 (ospitato su Azure) insieme ai dati di Microsoft Graph per generare contenuti e risposte. È disponibile solo come parte dei servizi cloud di Microsoft. Microsoft 365 Copilot è esplicitamente basato sul cloud, senza esecuzione locale/offline. Infatti, la documentazione Microsoft lo afferma chiaramente: “Microsoft 365 Copilot è basato sul cloud e non ha accesso alle cassette postali on-premises.”. Se i dati di un utente (come una casella Exchange) sono archiviati on-premises anziché in Exchange Online, Copilot non può accedervi. Tutta l'elaborazione avviene nel cloud di Microsoft 365, quindi senza accesso a internet Copilot non può funzionare. Anche gli esperti di settore avvertono: “Non aspettatevi di usare Copilot offline... Copilot non può funzionare senza accesso ai servizi Azure.”. In altre parole, senza internet non c'è Copilot in Office.

- GitHub Copilot – Un assistente AI per la programmazione che suggerisce codice all'interno del tuo IDE. GitHub Copilot si basa sui modelli OpenAI Codex/GPT ospitati da GitHub (ora una sussidiaria di Microsoft). Il tuo editor di codice invia il contesto del codice al servizio Copilot nel cloud, che restituisce i suggerimenti generati dall'IA. Questo significa che GitHub Copilot richiede una connessione internet attiva ogni volta che fornisce suggerimenti. Non esiste una modalità offline. Anche i forum di supporto di GitHub confermano: “Copilot necessita di una connessione a Internet poiché l'elaborazione avviene lato GitHub.”. Alla domanda su una versione on-premises per le aziende, la risposta è stata chiara: “Nessun piano per una versione on-premises di Copilot.”. Quindi oggi, sia per sviluppatori individuali che per imprese che utilizzano Copilot for Business, i completamenti di codice arrivano da un servizio cloud (con adeguate misure di sicurezza per proteggere il codice aziendale). Se gli sviluppatori sono completamente offline o in una rete senza accesso internet, GitHub Copilot non funziona.

- Windows Copilot – Introdotto con Windows 11 (2023) come assistente AI integrato, Windows Copilot ha inizialmente funzionato come un'interfaccia per Bing Chat (GPT-4) all'interno di Windows. Al momento del lancio, tutte le capacità di Windows Copilot (rispondere a domande, riassumere contenuti, controllare impostazioni) si basavano sul cloud – specificamente sull'intelligenza artificiale di Bing. Di conseguenza, richiedeva una connessione internet. I primi utenti hanno osservato che Copilot per Windows era sostanzialmente “un servizio online integrato in Windows” – se si era offline, non funzionava. Anche attività semplici come riassumere un documento o redigere una email richiedevano l'intelligenza artificiale nel cloud. Questo comportamento era identico sia su nuovi PC potenziati con AI che su vecchie macchine di 10 anni – senza internet, Copilot non era disponibile. In breve, la prima iterazione di Windows Copilot trattava il PC come un semplice canale verso l'AI nel cloud.

Perché la dipendenza dal Cloud?

Il filo conduttore è che queste esperienze Copilot si basano su modelli linguistici di grandi dimensioni (LLMs) troppo complessi per essere eseguiti sull'hardware locale standard (almeno fino a poco tempo fa). Microsoft 365 Copilot utilizza GPT-4; GitHub Copilot si basa su Codex e nuovi modelli derivati da GPT-4 per la chat; anche Bing/Windows Copilot utilizza GPT-4. Questi modelli hanno miliardi di parametri e richiedono potenti GPU – sono ospitati nel cloud Azure. L'esecuzione nel cloud consente inoltre a Copilot di integrare dati basati sul cloud (ad esempio documenti Microsoft 365, email o repository pubblici) e di applicare controlli di sicurezza aziendali centralizzati.

Tuttavia, la dipendenza dal cloud presenta delle sfide. Vediamo perché molte organizzazioni stanno richiedendo capacità offline o on-premises per Copilot e quali opzioni esistono attualmente.

Perché le aziende vogliono Copilot senza il Cloud

Per i decisori IT, la natura cloud-based di Copilot solleva importanti considerazioni in tema di connettività, privacy e conformità. Alcuni scenari in cui Copilot basato su cloud potrebbe non essere ideale includono:

Ambienti con connettività limitata o assente

Molti settori hanno utenti in località remote o isolate – pensa a piattaforme petrolifere, miniere, navi in mare, stazioni di ricerca sul campo, cliniche sanitarie rurali o missioni militari. In questi casi, una connessione internet affidabile non è garantita. Un ingegnere su una nave cargo o un soldato in una base operativa avanzata potrebbe trarre grande beneficio da un assistente AI, ma se richiede sempre internet, non è una soluzione praticabile. Questi utenti desiderano strumenti AI che funzionino offline o con connettività intermittente.

Severi requisiti di sicurezza e conformità dei dati

Settori altamente regolamentati (governo, difesa, finanza, sanità) spesso impongono politiche che vietano la trasmissione di dati sensibili su internet pubblico. Anche se il cloud di Microsoft è sicuro, l'idea che i dati di un utente lascino l'ambiente on-premises potrebbe violare le normative. Ad esempio, un ente governativo potrebbe apprezzare che Copilot riassuma un rapporto riservato, ma se ciò comporta l'invio del testo al cloud, si rischierebbe di infrangere i protocolli di sicurezza. Queste organizzazioni cercano soluzioni AI on-premises o private-cloud dove i dati rimangono sempre all'interno del loro ambiente controllato.

Latenza e affidabilità

Affidarsi ai servizi cloud significa che gli utenti sono soggetti a latenza e interruzioni di rete. Se la connessione è lenta o si interrompe, Copilot diventa lento o non disponibile. Nei flussi di lavoro mission-critical, questa incertezza è problematica. Un Copilot in grado di funzionare offline potrebbe garantire la continuità – assistenza AI disponibile anche durante le interruzioni di rete. Si tratta di resilienza: pensa a una situazione di risposta a un'emergenza durante un disastro naturale, dove internet non è disponibile ma un assistente AI potrebbe comunque aiutare ad analizzare i dati localmente.

Costi e larghezza di banda

Inviare continuamente dati al cloud per l'elaborazione AI può consumare banda e comportare potenziali costi (anche se Copilot è concesso in licenza per utente). Nelle filiali remote con connessioni a consumo o a bassa larghezza di banda, minimizzare il traffico cloud è auspicabile. Un modello AI locale potrebbe ridurre notevolmente il consumo di banda.

Percezione della privacy

Oltre alla sicurezza effettiva, alcune organizzazioni hanno una necessità culturale o legata ai clienti di mantenere i dati on-premises. Possono fidarsi del cloud Microsoft in linea di principio, ma preferiscono rassicurare gli stakeholder dicendo “l'AI funziona in locale, i tuoi dati non lasciano mai la nostra struttura”. È una garanzia per clienti o cittadini che le informazioni sensibili non transitino nemmeno temporaneamente su sistemi esterni.

Valore dei dati proprietari

Microsoft 365 Copilot e GitHub Copilot sono progettati in modo tale che i tuoi dati non vengano utilizzati per addestrare i modelli di base (i dati aziendali rimangono privati all'interno del tuo tenant) – Microsoft lo ha chiaramente dichiarato. Tuttavia, organizzazioni estremamente sensibili potrebbero comunque temere qualsiasi forma di esposizione. Avere un'AI che possa essere distribuita all'interno di un firewall – idealmente anche senza accesso a Internet – offrirebbe pieno controllo. Inoltre, consentirebbe una profonda personalizzazione dell'AI sui dati proprietari senza doverli inviare all'esterno.

Considerando queste motivazioni, non sorprende che subito dopo l'annuncio di Copilot, i clienti abbiano iniziato a chiedersi: “Ci sarà una versione on-premises o offline?”. Più avanti analizzeremo ogni offerta Copilot e cosa può (o non può) essere fatto per utilizzarla senza dipendenza dal cloud.

Microsoft 365 Copilot – Oggi solo su Cloud, ma possibile accesso dati ibrido

Microsoft 365 Copilot è l'assistente AI integrato nelle app di Office come Word, Excel, PowerPoint, Outlook, Teams e altro ancora. Può redigere documenti, creare presentazioni, riassumere email o chat, analizzare dati di Excel e rispondere a domande – sfruttando i dati della tua organizzazione su Microsoft 365 (SharePoint, OneDrive, Exchange Online, ecc.) oltre all'intelligenza di GPT-4. Per progettazione, questo servizio funziona nel cloud di Microsoft (nel servizio Azure OpenAI, all'interno dell'ambiente Microsoft 365).

Attualmente, non esiste un modo per eseguire localmente o offline i componenti LLM di Microsoft 365 Copilot – è necessaria una connessione Internet alla cloud di Microsoft 365 per utilizzarlo. Anche i dati su cui Copilot lavora risiedono solitamente nel cloud (ad esempio SharePoint Online, Exchange Online). Se non sei connesso, Copilot non ha nulla su cui operare. Come già detto, la documentazione Microsoft è esplicita: “Microsoft 365 Copilot è basato sul cloud.” Non può accedere a sistemi on-premises non integrati nel cloud.

Ad esempio, considera le email. Se la casella postale di un utente è in Exchange Online, Copilot può leggere le email (per cui l'utente ha autorizzazione) e riassumerle o rispondere. Ma se quella casella è su un server Exchange locale non accessibile da Microsoft 365, Copilot non includerà quelle email nelle sue analisi. Nelle configurazioni email ibride, Microsoft afferma che Copilot funzionerà solo con i contenuti in cloud e che “l’ancoraggio della casella postale (utilizzando dati email) non è supportato” se la casella è on-premises. In termini pratici, significa che Copilot potrà comunque rispondere a domande generiche o utilizzare file di SharePoint Online, ma ignorerà email e calendari locali.

Nessuna modalità offline

Cosa succede se l'utente è semplicemente offline (ad esempio, lavora su un laptop senza connessione)? In tal caso, le funzionalità di Copilot nelle app di Office non appariranno nemmeno o non funzioneranno. Tony Redmond di Practical 365 lo ha riassunto bene: “Copilot non funziona offline… ha bisogno di un accesso rapido ai servizi cloud e ai dati di Graph”. Anche se disponi di copie locali dei documenti tramite OneDrive Sync, l'elaborazione AI avviene comunque su Azure – quindi senza connettività, Copilot non può "pensare". Le app di Office potrebbero mostrare l'icona di Copilot disattivata se non sei connesso.

Accesso ibrido ai dati tramite Graph Connectors

Sebbene tu non possa eseguire il modello LLM di Copilot localmente, Microsoft 365 offre un modo per includere alcuni dati on-premises nell'ambito di Copilot: i Microsoft Graph connectors. I Graph connectors consentono alle organizzazioni di indicizzare fonti dati esterne (inclusi file share locali, SharePoint on-premises, servizi di terze parti, ecc.) nell'indice di ricerca di Microsoft 365. Una volta indicizzati nel cloud, questi dati diventano accessibili a Copilot per rispondere alle domande (poiché Copilot utilizza Microsoft Search/Graph per recuperare i contenuti rilevanti). Ad esempio, se hai file su un server file locale, puoi utilizzare il Windows File Share Graph Connector per scansionarli e indicizzarli in Microsoft 365. Successivamente, quando un utente pone una domanda a Copilot, questo può "basare" la risposta su quei file on-premises (ora rappresentati nell'indice cloud).

Questa non è una soluzione offline – comporta infatti la copia di metadati (e opzionalmente dei contenuti) nell'indice cloud – ma rappresenta un modo per collegare i dati on-premises al cloud di Copilot. In un forum della community di Microsoft, un amministratore ha chiesto se Copilot potesse includere dati da file share on-premises, e un rappresentante Microsoft ha confermato: “Sì – crea un Graph connector da M365 al tuo file share on-premises”. Il risultato è uno scenario ibrido: i tuoi dati rimangono on-premises per l'archiviazione primaria, ma una copia ricercabile è presente su Microsoft 365, rendendoli accessibili a Copilot. Ricorda che configurare i Graph Connectors richiede pianificazione (per l'indicizzazione della ricerca e la gestione dei permessi), e i dati saranno comunque inviati all'indice cloud di Microsoft 365, cosa che alcune organizzazioni ultra-sensibili potrebbero non consentire. Tuttavia, per molti rappresenta un compromesso efficace per dare visibilità a Copilot sui contenuti on-premises senza una migrazione completa dei dati.

Sicurezza e residenza dei dati

Microsoft ha lavorato per attenuare le preoccupazioni relative alla sicurezza cloud per Copilot. In particolare, Copilot (enterprise) non utilizza i dati privati degli utenti per addestrare i modelli pubblici – i dati e i prompt rimangono isolati all'interno del tenant dell'organizzazione. Microsoft 365 Copilot opera su Azure OpenAI all'interno dei confini controllati di Microsoft e non tramite l'API pubblica di OpenAI. Microsoft afferma che i prompt, i dati recuperati e le risposte rimangono all'interno del perimetro del tenant Microsoft 365. Qualsiasi caching è temporaneo e usato solo per la durata della sessione. Inoltre, se desideri impedire a Copilot di inviare dati a plugin esterni o a Bing per ricerche web, puoi controllarlo (ad esempio, se è abilitato il plugin di ricerca web, Copilot potrebbe occasionalmente chiamare l'API di ricerca Bing – ma gli amministratori possono disabilitarlo se lo ritengono opportuno). In sostanza, Microsoft vuole rassicurare i clienti scettici sulla cloud che Copilot in Microsoft 365 è pronto per l'uso aziendale dal punto di vista della privacy.

Tuttavia, per alcune organizzazioni ciò non è sufficiente – a causa di politiche interne o della mancanza di connettività, esse semplicemente non possono utilizzare un servizio cloud, indipendentemente dal livello di sicurezza. Per loro, la domanda diventa: Microsoft 365 Copilot sarà mai disponibile localmente o in un data center privato?

Prospettive future

Microsoft ha lasciato intendere che in futuro Copilot potrà sfruttare l'elaborazione locale, almeno in determinati scenari. Nel 2024, Microsoft ha annunciato i Copilot+ PC (tratteremo questo tema in dettaglio nella sezione Windows) – dispositivi Windows ottimizzati per l'IA dotati di NPUs (Neural Processing Units) che eseguono alcune attività AI localmente. Non a caso, i rapporti indicano che “Microsoft 365 Copilot sarà presto in grado di utilizzare l'NPU dei dispositivi Copilot+ per eseguire modelli AI localmente”.

Ciò suggerisce che, ad esempio, utilizzando Word su un Copilot+ PC, alcune funzionalità di Copilot potrebbero funzionare direttamente sul dispositivo senza dover comunicare costantemente con il cloud. Suggerimenti rapidi di grammatica/stile o semplici riassunti potrebbero essere elaborati in futuro da un modello locale più piccolo. Sebbene i dettagli siano ancora in fase di sviluppo, questo è un forte segnale che Microsoft sta esplorando architetture ibride per Copilot: le attività più complesse continueranno a richiedere il cloud (GPT-4), ma alcuni modelli di supporto (ad esempio per l'indicizzazione di contenuti locali o la comprensione parziale di documenti) potrebbero essere eseguiti localmente su hardware adeguato.

Inoltre, Microsoft ha esteso Microsoft 365 Copilot anche ai tenant Government Community Cloud (GCC) alla fine del 2024. Ciò significa che anche le organizzazioni del settore pubblico regolamentato possono utilizzare Copilot, ma sempre all'interno di un cloud gestito da Microsoft (l'ambiente GCC è separato dal cloud commerciale, ma non è on-premises). È importante notare che Copilot non è ancora disponibile in GCC High o DoD (le aree cloud statunitensi a massima sicurezza), il che indica che Microsoft sta ancora lavorando per soddisfare requisiti più rigorosi – come reti completamente isolate o livelli di sicurezza dei dati più elevati. È plausibile che in futuro Copilot venga reso disponibile in questi ambienti, che per definizione non hanno alcuna esposizione a Internet pubblico. Sarebbe una sorta di “cloud senza internet” – il servizio funzionerebbe in regioni Azure Government disconnesse dalla rete pubblica. Non sarebbe una vera soluzione on-premises sui server dei clienti, ma rappresenterebbe un passo avanti (un cloud dedicato).

In sintesi

Oggi, se vuoi usare Microsoft 365 Copilot, devi utilizzare il servizio cloud di Microsoft. Non esiste un'installazione on-premises. Tuttavia, puoi integrare dati on-premises tramite connettori e configurare la sicurezza di rete (ad esempio utilizzando collegamenti di rete privati ad Azure) per garantire che il traffico Copilot non passi su Internet pubblico (ne parleremo più avanti). La roadmap di Microsoft suggerisce che la capacità di utilizzare risorse locali (come NPUs) in combinazione con l'IA cloud aumenterà, ma un Microsoft 365 Copilot completamente offline non è ancora disponibile.

GitHub Copilot – Assistente di programmazione AI (e i suoi limiti in ambienti con restrizioni)

GitHub Copilot è diventato uno strumento molto popolare tra gli sviluppatori, offrendo suggerimenti di codice generati dall'IA e anche chat in linguaggio naturale per la programmazione. È disponibile come estensione per VS Code, Visual Studio, gli IDE JetBrains, ecc. Per le imprese esiste GitHub Copilot for Business, che offre una maggiore privacy (non conserva frammenti di codice, permette il blocco opzionale di segreti, ecc.). Nonostante queste differenze di licenza, l'architettura tecnica di base di GitHub Copilot è la stessa per tutti gli utenti: si basa sull'IA basata sul cloud di GitHub. Il modello (un discendente di OpenAI Codex, ora migliorato con GPT-4 per alcune funzionalità) è eseguito su server; il plugin IDE invia il contesto del codice al server e riceve i suggerimenti dall'IA.

Questo significa che GitHub Copilot non può funzionare nativamente sul tuo PC o server; richiede la connettività ai servizi di GitHub. Se la tua macchina di sviluppo è offline o priva di accesso a Internet, Copilot semplicemente non genererà nulla. A livello pratico, l’estensione mostrerà solo errori o nessun output se non riesce a raggiungere l’endpoint. Il team di GitHub è stato chiaro su questa limitazione. Durante sessioni di domande e risposte nella community, alcuni utenti hanno chiesto se potesse essere offerta una versione offline (per aziende senza accesso a Internet). La risposta ufficiale (nel 2022) è stata: “Copilot necessita dell'accesso a Internet... l'elaborazione avviene lato GitHub.” e che non vi erano piani per un Copilot on-premises come prodotto. Questa situazione rimane invariata anche nel 2025: GitHub Copilot è un servizio cloud.

Per molte aziende, questa dipendenza dal cloud è accettabile poiché GitHub ha implementato diverse misure di sicurezza aziendali: Copilot for Business garantisce che “i prompt e i suggerimenti non vengano conservati né utilizzati per addestrare il modello” e permette di limitare l'accesso di Copilot a specifici repository o tipi di file. In sostanza, il tuo codice proprietario non viene assorbito in un pool pubblico; viene elaborato al volo e poi dimenticato. Questo affronta alcune preoccupazioni legate alla proprietà intellettuale. Tuttavia, dal punto di vista di rete, gli sviluppatori devono comunque avere accesso a Internet per utilizzarlo. Le organizzazioni con ambienti di sviluppo isolati (comuni nel settore della difesa, in alcune aree della finanza e nello sviluppo software per infrastrutture critiche) trovano questa dipendenza un ostacolo. Per esempio, una banca che sviluppa software su una rete strettamente controllata senza accesso a GitHub non può permettere l’uso di Copilot, per quanto vantaggioso possa essere, perché non può comunicare con il servizio.

Soluzioni di rete aziendali

Se il problema non è tanto Internet in sé, ma la sicurezza dei dati in transito, un approccio è utilizzare controlli di rete per limitare l'accesso di Copilot solo agli endpoint necessari. Ad esempio, un’azienda potrebbe consentire alle macchine degli sviluppatori di connettersi solo agli endpoint API di GitHub Copilot (utilizzando regole di firewall o proxy) e a nient'altro su Internet. Il traffico verso Copilot è criptato (TLS) e con Copilot for Business si hanno garanzie sulla gestione dei dati. Questa configurazione richiede comunque una connessione a Internet, ma molto controllata. È un modo per mitigare il rischio: il codice va solo verso il cloud di GitHub e da nessun'altra parte. Alcune aziende instradano anche questo traffico attraverso una VPN o un collegamento privato. GitHub (tramite Azure) potrebbe essere potenzialmente accessibile attraverso un ExpressRoute o un'altra connessione di rete privata se configurato – rendendo di fatto il servizio cloud un’estensione della rete aziendale. (Si osservano pattern simili con i servizi Azure che usano Private Link – ne parleremo nella prossima sezione.) Anche se questo non rende Copilot “offline”, elimina almeno l'esposizione a Internet pubblico.

Alternative on-premises per l'IA di programmazione

Riconoscendo che alcune aziende non utilizzeranno un servizio cloud per la generazione di codice, alcuni fornitori terzi hanno iniziato a offrire strumenti simili a Copilot che possono essere eseguiti on-premises. Ad esempio, Codeium (un assistente di programmazione AI alternativo) offre una soluzione aziendale on-premises che può essere distribuita nell'ambiente del cliente con la garanzia che “nessun dato o telemetria lascia mai”. Questo offre in pratica un modello IA self-hosted per il codice. Tuttavia, queste alternative utilizzano modelli IA diversi (spesso modelli open source come CodeGen, SantaCoder o derivati di LLaMA) che potrebbero non eguagliare pienamente la potenza degli ultimi modelli di OpenAI. Il vantaggio è che possono essere containerizzati ed eseguiti su server GPU interni, dietro il proprio firewall, risultando davvero offline (dopo l’installazione iniziale). Le grandi aziende con politiche severe potrebbero valutare queste opzioni se GitHub Copilot fosse inaccessibile.

Un’altra possibilità è utilizzare l'Azure OpenAI Service per costruire un proprio "Copilot" personalizzato. Azure OpenAI fornisce API ai modelli di OpenAI (Codex, GPT-3.5, GPT-4) con la protezione aziendale di Azure. Sebbene Azure OpenAI sia ancora un servizio cloud, si potrebbe ospitare un piccolo servizio web interno che interagisca con il modello di completamento del codice di Azure OpenAI per conto degli sviluppatori. In questo modo, tutti i flussi di codice rimarrebbero all'interno del proprio tenant Azure controllato. È anche possibile utilizzare Private Endpoints in modo che le chiamate ad Azure OpenAI non attraversino Internet pubblico, ma viaggino attraverso un collegamento di rete privata. In sostanza, si tratta ancora di cloud, ma può essere reso simile a un'estensione privata del proprio data center (ad esempio tramite un circuito ExpressRoute verso Azure). Gli IDE degli sviluppatori potrebbero essere configurati per puntare a questo servizio interno per i completamenti AI. Questo approccio richiede un notevole lavoro di personalizzazione (non è immediato come l'integrazione di GitHub Copilot in VS Code), ma rappresenta un compromesso praticabile per alcuni: si ottiene un'assistenza AI simile utilizzando i modelli cloud di Azure, ma con isolamento di rete e forse un maggiore controllo diretto sui prompt e sulle risposte (che si potrebbero anche registrare o filtrare se necessario).

Limitazioni attuali

Alla fine della giornata, se "no cloud" significa davvero nessun cloud, allora GitHub Copilot attualmente non è un'opzione. Gli sviluppatori che lavorano in reti completamente isolate (air-gapped) non possono usarlo. Dovrebbero affidarsi a strumenti di analisi statica o a vecchi assistenti ML locali (alcuni IDE offrono funzioni di completamento del codice basate su ML offline, addestrati sul codice locale – ma non sono nemmeno lontanamente paragonabili alle capacità di Copilot). Alcune organizzazioni sperano che Microsoft/GitHub offrano in futuro un appliance Copilot self-hosted o un modello eseguibile su Azure Stack (Azure on-premises). Finora non esiste alcuna roadmap pubblica in tal senso – si presume che il ritmo di miglioramento dei modelli e l'integrazione con la piattaforma cloud di GitHub rendano difficile proporre un prodotto on-premises.

Tuttavia, la domanda esiste chiaramente – soprattutto perché gli assistenti di programmazione AI stanno diventando uno standard. Microsoft potrebbe continuare a rassicurare le imprese tramite politiche specifiche: ad esempio, aggiornamenti futuri potrebbero permettere di eseguire GitHub Copilot interamente tramite Azure OpenAI nel proprio tenant (così che anche l'inferenza avvenga in un'istanza Azure controllata dal cliente). Questo soddisferebbe chi vuole che sia "il proprio cloud" anziché un servizio multi-tenant di GitHub. Staremo a vedere. Per ora, se l'uso offline di un LLM per la programmazione è un requisito, bisogna guardare oltre Copilot ufficiale, esplorando soluzioni open source o di terze parti, accettando però un possibile calo di qualità rispetto al modello all'avanguardia utilizzato da GitHub Copilot.

Windows Copilot – Verso un modello AI ibrido (Locale + Cloud)

Windows Copilot (introdotto in Windows 11) è unico perché è integrato direttamente nel sistema operativo, con l'obiettivo di assistere sia nelle query web/cognitive sia nelle attività specifiche del PC (come regolare impostazioni o riassumere ciò che è visualizzato sullo schermo). Inizialmente, l'intelligenza di Windows Copilot si basava essenzialmente su Bing Chat – quindi tutto era alimentato dal cloud (OpenAI GPT-4 tramite Bing). Ma molto rapidamente, Microsoft ha annunciato un passaggio a un approccio ibrido, sfruttando l'hardware locale. Questo riflette una visione più ampia: portare capacità AI direttamente sui PC in modo che non tutto debba avvenire lato server.

Nel giugno 2024, Microsoft (insieme a partner hardware) ha annunciato i “Copilot+ PC” – una nuova classe di PC Windows 11 equipaggiati con potenti NPU (unità di elaborazione neurale) e uno speciale Windows Copilot Runtime. Queste macchine (come i dispositivi Surface con processori Qualcomm Snapdragon e i futuri modelli Intel Core Ultra con NPU) sono progettate per eseguire molteplici modelli AI localmente, direttamente sul dispositivo. Microsoft ha rivelato che i PC Copilot+ certificati includono il Windows Copilot Runtime, con oltre 40 modelli AI eseguiti interamente sui laptop. È una svolta significativa rispetto al modello basato esclusivamente sul cloud. In pratica, Windows ora integra una serie di modelli AI pre-caricati (per visione, linguaggio, audio, ecc.) che possono funzionare su NPU o altri acceleratori locali, consentendo a molte funzionalità di Copilot di funzionare offline o con prestazioni migliorate.

Quali tipi di attività possono gestire questi modelli locali? Secondo Microsoft e i report tecnici, l'

“Recall” (Ricerca semantica personale)

Questa funzionalità indicizza tutto ciò che hai visto o fatto sul tuo PC (file, finestre, app, screenshot in una linea temporale) e ti permette di eseguire ricerche semantiche. Recall utilizza un indice semantico personale costruito e conservato interamente sul dispositivo, con snapshot salvati localmente. In altre parole, è come avere un "modello di memoria" locale che può rispondere a domande sulle tue attività, senza bisogno di interrogare un server cloud. Funziona offline mantenendo i dati privati sul PC.

Generazione ed editing di immagini (Cocreator, Paint, Foto)

Windows integra ora un generatore di immagini AI (simile a DALL-E o Stable Diffusion). Sui PC Copilot+, questo processo avviene sulla NPU locale. Microsoft ha sottolineato che, mentre i generatori di immagini cloud possono avere limiti o tempi di attesa, la generazione locale tramite NPU può avvenire “quasi in tempo reale”. Puoi scrivere un prompt e ottenere un'immagine creata localmente, oppure applicare effetti AI alle tue foto (come cambiare lo stile di una foto) con “Restyle” nell'app Foto – tutto senza bisogno di collegarsi a un servizio cloud. Addirittura si vanta che sui PC Copilot+ puoi generare immagini infinite gratuitamente e velocemente, proprio perché avviene localmente.

Trascrizione e traduzione audio in tempo reale

Funzionalità come i sottotitoli in tempo reale o la traduzione del parlato possono essere gestite da modelli AI locali (ad esempio un piccolo modello di riconoscimento vocale e uno di traduzione sulla NPU). Anche in questo caso, si elimina la necessità di API cloud mantenendo i dati audio in locale.

Visione e riconoscimento del contesto

Microsoft ha dimostrato che Copilot (su questi nuovi PC) può "vedere" ciò che appare sullo schermo o nelle app aperte e offrire assistenza. Questo probabilmente sfrutta modelli di visione locali (per il riconoscimento degli elementi UI, ecc.) eseguiti sul PC. Per esempio, Copilot potrebbe riconoscere uno screenshot o un'immagine e offrire contesto, il tutto localmente prima di un'eventuale query al cloud.

È fondamentale sottolineare l'aspetto della privacy di queste capacità locali: “Tutto funziona offline e sul tuo PC in modo più rispettoso della privacy – senza inviare i tuoi dati personali a server cloud per l'elaborazione.”. Questa affermazione di una recensione di PCMag sui PC Copilot+ sottolinea che attività come la ricerca sul PC o la generazione di immagini avvengono interamente offline, permettendo a tali funzionalità di Copilot di funzionare anche senza connessione internet, senza che alcun dato (file, immagini) lasci il dispositivo.

Tuttavia, non tutte le query di Copilot verranno gestite offline su questi PC...

Microsoft ha chiarito che “alcuni compiti utilizzeranno ancora modelli di IA eseguiti in data center remoti” – presumibilmente per le funzioni di chat generale o il ragionamento complesso che GPT-4 fornisce. Ad esempio, se chiedi a Copilot di scrivere una lunga email o di generare codice non presente localmente, il PC potrebbe ancora inviare la richiesta al cloud per sfruttare tutta la potenza del modello più grande. I modelli locali (che potrebbero avere un ordine di grandezza tra 1,5 miliardi e 7 miliardi di parametri, come suggerito dai modelli "DeepSeek" che Microsoft sta implementando) sono ottimi per compiti contestuali rapidi, ma per il linguaggio naturale aperto, il modello cloud probabilmente rimane superiore.

Questo modello ibrido è in realtà molto interessante: il tuo PC gestisce ciò che può (veloce, privato, capace di funzionare offline), e si collega al cloud solo per i compiti più pesanti. È analogo a come gli smartphone eseguono alcune funzioni AI sul dispositivo (come la dettatura vocale o il riconoscimento immagini di base) e utilizzano l’IA cloud per query più complesse.

Dal punto di vista aziendale, l’arrivo dei PC Copilot+ significa che gli utenti sul campo potrebbero presto avere funzionalità parziali di Copilot anche offline. Immagina un operatore di un giacimento petrolifero con un dispositivo Copilot+ robusto: potrebbe utilizzare Recall per interrogare i dati degli ultimi 2 giorni, generare immagini per visualizzare concetti, o ottenere trascrizioni in tempo reale di una riunione, tutto offline. Quando si ricollega, eventuali query complesse in sospeso potrebbero essere elaborate dall'IA cloud. Questo potrebbe aumentare notevolmente l’utilità di Copilot in situazioni di scarsa connettività.

Microsoft sta inoltre realizzando strumenti per permettere agli sviluppatori di sfruttare questo runtime AI locale. Il Windows Developer Blog ha annunciato che gli sviluppatori possono indirizzare il Windows Copilot Runtime e le NPU per includere funzionalità AI nelle proprie app. Ciò significa che app di terze parti o applicazioni aziendali interne potrebbero distribuire modelli AI personalizzati da eseguire localmente sui PC degli utenti. Si può immaginare un’impresa che distribuisce un modello AI specifico per il controllo della conformità o per l’analisi specializzata dei dati, eseguendolo su tutti i laptop dei dipendenti tramite il runtime Copilot – senza bisogno del cloud per quella funzione specifica.

La visione generale...

L’evoluzione di Windows Copilot dimostra la strategia di Microsoft di combinare cloud e edge AI. Il team di Windows ha dichiarato esplicitamente che “l'IA si sta avvicinando sempre più all'edge, e i PC Copilot+ stanno aprendo la strada.”. Ottimizzando e distillando i modelli per l'esecuzione su NPU, Microsoft sta preparando il terreno per esperienze Copilot che si degradano in modo graduale quando si è offline, invece di smettere completamente di funzionare. Oggi ciò è più evidente sull’hardware specializzato, ma col tempo queste NPU diventeranno comuni nella maggior parte dei PC aziendali. Possiamo aspettarci che il confine tra ciò che viene eseguito localmente e ciò che viene eseguito nel cloud si sposti man mano che l'hardware locale diventa più AI-friendly. Forse tra uno o due anni anche un normale PC sarà in grado di eseguire localmente un modello di dimensioni considerevoli – il che significa che Microsoft 365 Copilot potrebbe rispondere ai prompt semplici localmente e inviare richieste al cloud Azure solo per richieste molto complesse o per accedere a dati aziendali centralizzati. Questo approccio a livelli potrebbe alleviare molte preoccupazioni relative alla connessione internet costante.

In sintesi, Windows Copilot nella sua ultima forma è il primo Copilot a offrire vere funzionalità offline (per determinate funzionalità). Rappresenta il riconoscimento da parte di Microsoft che richiedere il cloud per ogni operazione non è ideale. Le aziende dovrebbero monitorare questa evoluzione, poiché le tecniche consolidate in Windows (indici semantici locali, modelli distillati come "DeepSeek" per la ricerca, ecc.) potrebbero in futuro essere applicate anche alle app Office o ai prodotti server. È uno sviluppo promettente per chi ha bisogno di assistenza AI in scenari disconnessi – sarà possibile dotare gli utenti di dispositivi capaci di fornire assistenza AI anche senza connessione.

Eseguire il proprio Copilot: implementazioni locali di LLM e opzioni aziendali

Se un'organizzazione non può utilizzare le versioni cloud di Copilot, un'alternativa è tentare di implementare modelli linguistici di grandi dimensioni (LLM) on-premises o in un ambiente privato per replicare alcune delle funzionalità di Copilot. Si tratta essenzialmente di un approccio "fai-da-te" per ottenere un “assistente AI” senza dipendere dal cloud di Microsoft. Quali sono le possibilità e le limitazioni in questo scenario?

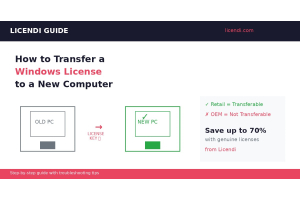

Azure OpenAI in una rete privata

Abbiamo già accennato a questo tema: sebbene Azure OpenAI Service sia un servizio cloud, puoi isolarlo usando Private Link/Endpoints affinché, dal punto di vista aziendale, si comporti come un servizio interno. Microsoft consente di bloccare un'istanza Azure OpenAI a una specifica rete virtuale e persino di impedire qualsiasi accesso pubblico da Internet. I client (le tue applicazioni o servizi) si connettono tramite quella rete privata. Il percorso dei dati rimane interamente all'interno della rete sicura di Azure o della tua connessione ExpressRoute. Questo mitiga il rischio di esposizione a Internet e garantisce che nessun altro tenant possa accedere alla tua istanza. Molte aziende adottano questo modello per carichi di lavoro sensibili: l'LLM è "su Azure", ma solo la tua organizzazione può comunicare con esso, e tutto il traffico è criptato e rimane in determinate regioni. Non è offline, ma può sembrare una estensione privata della tua infrastruttura.

Inoltre, Azure OpenAI ha recentemente introdotto “Azure OpenAI on Your Data”, che consente di indicizzare i dati interni (ad esempio file, knowledge base) e permettere al modello di basare le risposte su tali dati, il tutto all'interno del tuo ambiente. È come costruire un chatbot che conosce i documenti della tua azienda. Anche in questo caso non si tratta di un sistema offline, ma puoi ospitare tutti i componenti in Azure o su connessioni on-premises, evitando dipendenze da Internet pubblico o da servizi multi-tenant. Se è necessario essere completamente offline per un periodo, si potrebbe memorizzare nella cache parte dei dati o preeseguire alcune query, ma in generale Azure OpenAI richiede comunque la connessione.

Azure AI Edge Containers

Microsoft ha iniziato a offrire anche Azure AI in container per l'uso offline (in anteprima, per alcuni servizi cognitivi). Uno Specialista Tecnico di Microsoft ha evidenziato che “gli Azure AI Offline Containers sono fondamentali per distribuire soluzioni AI in ambienti con connettività Internet limitata o assente,” confezionando i modelli per l'esecuzione localmente su dispositivi edge o server on-premises. Attualmente includono servizi come riconoscimento vocale, traduzione linguistica e altri Cognitive Services containerizzati. Il vantaggio è chiaro: nessuna dipendenza dal cloud – il container contiene il modello e il runtime necessari, permettendo il deployment in un laboratorio disconnesso, per esempio. Tuttavia, Azure OpenAI (modelli GPT) non era ancora disponibile in questa modalità all'inizio del 2024. Il programma dei container offline è limitato a clienti strategici e a casi d'uso specifici. Ciò suggerisce che Microsoft sta lavorando per rendere disponibili più servizi AI in modalità completamente offline per chi ne ha reale necessità (es. clienti governativi o della difesa). È plausibile che in futuro venga offerta una versione containerizzata di un modello simile a GPT-4 a clienti selezionati con l’hardware necessario. Questo consentirebbe a un'impresa di eseguire un "cervello Copilot" on-premises, completamente offline, anche se probabilmente a costi elevati (richiedendo rack di GPU o NPU specializzate).

I principali vantaggi dei container AI offline sono la continuità operativa, la privacy dei dati, la bassa latenza, ecc. – esattamente i motivi per cui le imprese desiderano un Copilot offline. Microsoft è consapevole di queste esigenze e le sta affrontando in altri ambiti dell'IA. Finora, i LLM rimangono una sfida a causa delle loro dimensioni, ma è solo questione di tempo e di ottimizzazione.

LLM open-source on-premises

Se le soluzioni ufficiali di Microsoft non sono ancora disponibili, alcune organizzazioni stanno sperimentando modelli linguistici di grandi dimensioni open-source che possono essere eseguiti on-premises o persino su singole macchine. Negli ultimi anni si è assistito a una proliferazione di modelli come LLaMA 2 di Meta, che nelle versioni da 7B o 13B parametri può essere eseguito su un singolo server di fascia alta (o anche su un laptop potente con GPU) – e nella versione da 65B può essere eseguito su un server multi-GPU robusto. Questi modelli possono essere perfezionati (fine-tuned) sui dati aziendali e fungere da Copilot di base per uso interno. Per l'assistenza alla programmazione, modelli come StarCoder o Code Llama sono stati utilizzati per costruire funzionalità simili a Copilot senza dipendere da servizi cloud. Esistono progetti open-source che integrano questi modelli in VS Code, ad esempio, abilitando il completamento del codice offline (sebbene con una precisione inferiore rispetto ai suggerimenti basati su GPT-4 di GitHub Copilot).

Il compromesso con i modelli open-source riguarda qualità e manutenzione. Spesso sono inferiori agli standard più recenti in termini di coerenza e accuratezza. Detto ciò, il divario si sta riducendo: un modello perfezionato da 70B parametri può svolgere molto bene molti compiti – anche se può ancora faticare con il ragionamento complesso o l'ampiezza delle conoscenze in cui eccelle GPT-4. Inoltre, eseguire questi modelli richiede risorse IT (GPU, storage, ecc.) e competenze ML per l'implementazione e l'aggiornamento continuo. Diventa un progetto interno per “possedere” l'IA. Per alcune grandi imprese e agenzie governative, ciò è accettabile (anzi, preferibile). Per altre, rappresenta una barriera troppo alta, preferendo attendere che Microsoft o un altro fornitore proponga una soluzione on-premises gestita.

Implementazioni ibride con connettività periodica

Un'altra strategia è operare in modalità “connessi a volte”. Forse il tuo ambiente è offline per la maggior parte del tempo ma può connettersi durante finestre programmate (ad esempio sincronizzazioni giornaliere o settimanali). In tali casi, si potrebbe utilizzare Copilot a lotti – ad esempio, quando connessi, far generare a Copilot una serie di contenuti o analisi da utilizzare offline fino alla successiva sincronizzazione. Non è un utilizzo in tempo reale di Copilot, ma è un modo per sfruttare il cloud quando disponibile a beneficio dei periodi offline. Un esempio: una squadra su un sottomarino si connette una volta a settimana; durante quel tempo potrebbero inviare a Copilot tutti i rapporti e i dati raccolti e chiedergli di produrre analisi da utilizzare successivamente in immersione, senza connessione. Questo approccio richiede pianificazione e non è immediato come l'uso su richiesta, ma rappresenta una soluzione creativa per certi flussi di lavoro.

Riepilogo delle possibilità locali

Gestire un proprio “Copilot” locale è oggi fattibile per scopi specifici e limitati (utilizzando modelli open-source), ma per vivere l'esperienza completa di Copilot con intelligenza a livello GPT-4 in più domini, siamo ancora in gran parte vincolati al cloud. Microsoft sta procedendo nella giusta direzione con opzioni di networking privato e runtime edge. Durante sessioni di domande e risposte, Microsoft ha suggerito che “potrebbe rilasciare una versione on-premises in futuro” per Azure OpenAI, ma senza indicare una tempistica. Incoraggiano i clienti che necessitano di questa funzionalità a fornire feedback attraverso i canali ufficiali – segno che è già sotto osservazione. Considerando i rapidi sviluppi, non è inverosimile che entro un paio d'anni Microsoft possa offrire un modello AI ridotto ma distribuibile localmente per alcune funzionalità Copilot – soprattutto man mano che le NPU e l’hardware specializzato diventeranno più diffusi (rendendo economicamente sostenibile distribuire modelli AI sui dispositivi dei clienti anziché solo nei datacenter Microsoft).

Per ora, le imprese che devono evitare il cloud hanno queste scelte: utilizzare l'approccio cloud privato di Azure (mantenendo tutto all'interno del proprio tenant senza esposizione pubblica), oppure investire in implementazioni AI alternative (soluzioni open-source o di terze parti on-premises), accettandone però le limitazioni. Molte adottano un approccio attendista – mettendo Copilot in pausa per il momento, ma monitorando gli aggiornamenti di Microsoft che si avvicinano ai loro requisiti. Chi invece può tollerare un minimo di cloud, sta iniziando a provare Copilot per utenti meno sensibili o in ambienti sandbox, per valutarne i benefici.

Strategie per ambienti con connettività limitata: ottenere valore da Copilot

Sebbene l'utilizzo completamente offline di Copilot sia attualmente limitato, esistono strategie per massimizzare i benefici di Copilot in ambienti a bassa connettività o ad alta sicurezza:

1. Utilizzare Copilot in una zona di rete controllata

Se l'uso diretto di Internet è vietato, si può considerare di configurare una zona o un terminale controllato che abbia accesso a Copilot. Ad esempio, alcune organizzazioni utilizzano una “workstation di ricerca” che può connettersi all'esterno (attraverso canali monitorati), mentre i PC normali non possono. Un analista può usare Copilot su quella postazione per ottenere assistenza AI senza esporre l'intera rete. Non è un uso offline, ma compartimentalizza il rischio. È come avere una stanza sicura dove far girare Copilot e portare dati dentro/fuori in modo gestito (assicurandosi, ad esempio, di non inviare dati realmente sensibili o utilizzando dati surrogati). Questa strategia può essere combinata con Bing Chat Enterprise, un'altra offerta AI di Microsoft: è sostanzialmente la chat GPT-4 di Bing, ma con garanzie che i prompt non vengano memorizzati o utilizzati per addestrare l'IA e che i dati rimangano all'interno della propria organizzazione. Bing Chat Enterprise può essere usato da team legali o HR per query generali con contesto sensibile, senza che Microsoft registri i dati oltre a fornire la risposta. È ancora cloud, ma con una privacy molto rafforzata.

2. Utilizzare Private Link e VPN

Come discusso, configura una connettività privata al cloud di Microsoft per i servizi Copilot. Usando Azure ExpressRoute o tunnel VPN, puoi garantire che tutto il traffico di Copilot passi attraverso la tua rete sicura direttamente verso Microsoft, senza attraversare Internet aperto. Questo riduce i rischi di intercettazione o esposizione. Di fatto, rende i servizi Microsoft 365 o Azure un'estensione della tua intranet. Combinato con la crittografia dei dati (attiva per impostazione predefinita) e gli accordi aziendali Microsoft, spesso soddisfa i requisiti di conformità. È una soluzione tecnica che non cambia la natura cloud di Copilot, ma la rende più accettabile in molti scenari.

3. Integrare i dati on-premises tramite Graph Connectors

Abbiamo accennato a questo per M365 Copilot: se gli utenti devono principalmente lavorare con documenti o conoscenze interne conservate on-premises, pianifica di integrare quei dati in Microsoft 365 in modo sicuro. I Graph Connector per file share, database on-premises, wiki, ecc., possono essere configurati per permettere a Copilot di rispondere alle domande utilizzando quei dati. In questo modo, anche se la fonte originale resta on-premises, l'IA non ha bisogno di accedervi dinamicamente (cosa che non potrebbe fare); invece, le informazioni rilevanti vengono indicizzate nel cloud in anticipo. È una sorta di "caching" della conoscenza aziendale. Bisogna gestire il security trimming (assicurando che Copilot mostri informazioni solo a chi ne ha diritto) – cosa gestita da Microsoft Search/Graph se configurata correttamente. Il vantaggio è che gli utenti ricevono risposte arricchite da Copilot che includono contenuti dai propri file on-premises – altrimenti inaccessibili. Il costo è l'impostazione iniziale e un processo continuo di sincronizzazione.

4. Educare e creare sandbox per i dati sensibili

Una parte fondamentale del deployment di Copilot in qualsiasi contesto è l'educazione degli utenti su cosa si può o non si può condividere con l'IA. Anche senza puntare all'uso offline, per la conformità potresti istruire gli utenti, ad esempio, a “non incollare contenuti segreti/classificati nei prompt di Copilot” finché non sarà disponibile un modello pienamente privato. Alcune organizzazioni già applicano politiche interne sull’uso delle IA generative. Guidando correttamente gli utenti, si riduce il rischio che, inconsapevolmente, trasmettano dati sensibili a un'IA cloud. Nei progetti estremamente sensibili, gli utenti potrebbero operare senza Copilot (in modo tradizionale) e riservarne l’uso a compiti meno critici. Col tempo, con la crescita della fiducia o l'emergere di opzioni più offline, queste linee guida potranno essere adattate.

5. Monitorare e migliorare continuamente

Abilita tutte le funzionalità di logging o auditing disponibili. Per Microsoft 365 Copilot puoi usare gli strumenti Microsoft Purview per monitorare l’uso di Copilot e verificare che non vi siano esposizioni indebite di dati. In GitHub Copilot for Business puoi ottenere telemetria sui suggerimenti. Il monitoraggio aiuta a costruire fiducia nell'uso sicuro di Copilot, anche se basato su cloud – e i dati raccolti possono evidenziare dove è veramente necessario un modello offline rispetto a dove l'uso del cloud va bene. Potresti scoprire, ad esempio, che Copilot non tenta mai di utilizzare dati particolarmente sensibili, o che certi team (magari quelli in segmenti sicuri) non lo usano molto – concentrando così gli sforzi di miglioramento proprio su quei team.

6. Valutare l’hardware Copilot+ per l’uso sul campo

Se hai dipendenti spesso offline (consulenti che viaggiano in siti clienti con Wi-Fi scarso, tecnici in aree remote), considera di equipaggiarli con i nuovi PC Copilot+ o dispositivi con NPU man mano che diventano disponibili. Le funzionalità AI locali su questi dispositivi potrebbero migliorare notevolmente la produttività sul campo. Ad esempio, un consulente in volo (senza internet) potrebbe comunque utilizzare le capacità offline di Copilot per organizzare appunti (tramite Recall), generare immagini per un rapporto o trascrivere una riunione precedente – attività che prima richiedevano l'IA cloud. Quando si riconnettono, possono sincronizzarsi e usare il Copilot completo per compiti più complessi. Microsoft e i produttori OEM probabilmente promuoveranno fortemente questi PC AI per le imprese nel 2025; i responsabili IT dovrebbero testarli per valutare se forniscono reali benefici AI offline che giustifichino l’aggiornamento dei dispositivi. È fondamentalmente portare parte dell’intelligenza cloud direttamente ai dispositivi endpoint – una mossa intelligente per certi ruoli.

7. Pianificare implementazioni ibride future

Nella strategia di investimenti IT e cloud, tieni d’occhio la roadmap di Copilot di Microsoft. Il trend va verso la flessibilità: forse Azure Stack (Azure on-premises) potrà un giorno ospitare modelli AI utilizzabili da Copilot, oppure esisterà un “Copilot Appliance” per grandi imprese. Microsoft sta anche abilitando Copilot Studio, dove le organizzazioni possono costruire propri mini copilots (con plugin e prompt personalizzati) – attualmente all'interno dell'ecosistema cloud, ma in futuro forse distribuibili anche su cloud privati. È importante preparare l'architettura IT (identità, networking, hardware) per integrare queste soluzioni AI ibride. Ad esempio, investendo in dispositivi con NPU, configurando il proprio ambiente Azure con Private Link, o formando il team nella gestione dei modelli AI – tutto questo può posizionarti per sfruttare rapidamente le funzionalità offline o semi-offline di Copilot non appena saranno disponibili.

Roadmap di Microsoft: verso un Copilot opzionale al cloud?

Il messaggio di Microsoft intorno a Copilot è stato “IA ovunque”, e sempre più “ovunque” include edge, dispositivi e ambienti cloud di ogni tipo. Vediamo passi concreti: Windows che sfrutta l'AI locale, Microsoft 365 Copilot che si espande ai cloud governativi, Azure che offre endpoint di modelli privati, e accenni a future possibilità on-premises.

Vale la pena notare la visione di Satya Nadella – parla spesso di computing distribuito e di come l'IA farà parte di ogni piattaforma che utilizziamo. Parte di quella distribuzione sarà “AI all'edge”, cioè un’IA che non vive solo nei grandi datacenter ma anche su telefoni, laptop, server on-premises. Gli investimenti di Microsoft nelle NPU (es. Surface Pro con processori SQ, partnership con Qualcomm e Intel sui chip AI) mostrano che puntano su carichi di lavoro AI locali. Anche la partnership con Meta per portare LLaMA 2 su Azure e il supporto ai modelli open-source potrebbero giocare un ruolo: Microsoft potrebbe integrare modelli più piccoli per alcuni compiti di Copilot eseguibili localmente o consentire ai clienti di inserire i propri modelli in alcuni casi.

Occorre moderare le aspettative...

Le migliori capacità di Copilot dipendono ancora da modelli molto grandi che nel 2025 sono impraticabili da eseguire completamente on-premises per la maggior parte dei clienti. È improbabile che questo cambi subito. Quello che cambierà è il mix tra elaborazione cloud e locale e le opzioni su dove avverrà tale elaborazione (cloud pubblico vs privato). Microsoft 365 Copilot continuerà a utilizzare qualcosa come GPT-4 ospitato in Azure – ma forse si potrà scegliere di ospitare l'istanza nel datacenter del proprio paese, o su server dedicati isolati per la propria azienda. GitHub Copilot potrebbe rimanere un servizio cloud multi-tenant ancora per un po’, ma forse Azure DevOps introdurrà una AI simile ospitabile. Abbiamo già Azure DevOps Services vs Server come analogia – potrebbe arrivare un “AI addon” per Azure DevOps Server, addestrato sul proprio codice ed eseguito sui propri server. Sono speculazioni, ma allineate con l'evoluzione tipica dei software enterprise (prima cloud, poi opzioni on-premises).

La risposta di Microsoft in una sessione Q&A riguardo all'IA on-premises (Azure OpenAI) è rivelatrice: “stiamo lavorando per migliorare continuamente… potremmo rilasciare una versione on-premises in futuro.”. Sono consapevoli che i concorrenti potrebbero soddisfare la domanda on-prem. Aziende come IBM, ad esempio, propongono soluzioni AI eseguibili nei data center dei clienti. Anche CodeWhisperer di Amazon (simile a Copilot) non ha attualmente un'opzione on-premises, ma AWS potrebbe offrire modelli su AWS Outposts (hardware on-premises). Microsoft non vorrà perdere i grandi clienti che insistono su soluzioni non cloud, quindi aumenterà la pressione per offrire qualcosa.

In conclusione, la direzione è chiara: Microsoft sta gradualmente riducendo la dipendenza di Copilot dal proprio cloud, abilitando il tuo cloud o i tuoi dispositivi a svolgere più lavoro. Siamo passati da “Copilot = solo cloud” all’inizio del 2023 a “Copilot può sfruttare 40 modelli locali su un PC” alla fine del 2024. Non è impensabile che entro la fine del 2025 si parli di Copilot per Azure Stack (ipotesi) o di un'espansione dei container offline per includere certi modelli linguistici. Le imprese dovrebbero coinvolgere Microsoft attraverso i propri account team per esprimere interesse per queste funzionalità – spesso funzionalità come i container offline in anteprima vengono offerte ai clienti strategici. Se la tua organizzazione rientra in questa categoria (infrastrutture critiche, difesa, ecc.), potrebbero esserci programmi pilota per portare l'IA tipo Copilot nel tuo ambiente prima di altri.

Conclusione: prepararsi a un futuro AI ibrido

Oggi, Microsoft Copilot – sia in Office, GitHub o Windows – si basa ancora fortemente su AI cloud-based, il che significa che una connessione internet e fiducia nella sicurezza cloud sono prerequisiti. L'uso completamente offline di Copilot non è ancora generalmente disponibile, fatta eccezione per alcune funzionalità emergenti su dispositivi Windows specializzati. Le organizzazioni con politiche di totale esclusione del cloud non possono ancora distribuire Copilot su larga scala nei loro ambienti.

Tuttavia, Microsoft sta attivamente colmando il divario tra cloud e on-premises. Attraverso implementazioni di cloud privato, runtime AI locali sui dispositivi e future offerte on-premises, la dipendenza dal cloud si sta gradualmente riducendo. Nel frattempo, le imprese possono adottare un approccio ibrido: mantenere i flussi di lavoro meno sensibili nel cloud per sfruttare appieno Copilot e utilizzare workaround (o strumenti alternativi) per aiutare gli utenti offline o in zone sicure. Anche un uso parziale di Copilot può portare guadagni di produttività significativi – ad esempio, gli impiegati d'ufficio possono usare Copilot per automatizzare attività di documentazione (cloud), mentre gli ingegneri sul campo usano una AI locale più leggera per le trascrizioni (edge).

È anche importante valutare il valore aziendale che Copilot offre rispetto alle sfide legate alla dipendenza dal cloud. Molte organizzazioni hanno scoperto che il boost di produttività offerto da Copilot – redigere contenuti in pochi secondi, accelerare la programmazione, scoprire insight dai dati – è significativo. Questo crea una spinta interna a trovare un modo per adottare Copilot in sicurezza anziché rifiutarlo a priori. I leader IT si trovano a dover bilanciare innovazione e rischio. La buona notizia è che gli impegni di Microsoft a livello enterprise (privacy, compliance, strumenti) hanno rassicurato molti CIO a sperimentare Copilot in modo controllato. Man mano che queste sperimentazioni dimostrano valore, si potrà spingere oltre i limiti, portando a un'adozione più ampia o a richieste verso Microsoft di maggiori funzionalità offline.

Nel pianificare l'adozione di Copilot nella tua organizzazione, considera:

- Casi d'uso: Identifica quali attività Copilot potrebbe rivoluzionare (es. generazione di report, revisioni di codice, domande alla knowledgebase) e valuta i requisiti di connettività di tali attività.

- Connettività: Migliora i percorsi di rete verso il cloud di Microsoft (banda larga, bassa latenza, Private Link) affinché l'uso di Copilot sia fluido e sicuro. Una connessione veloce e affidabile può ridurre molte frustrazioni degli utenti e preoccupazioni sulla sicurezza.

- Policy: Sviluppa linee guida chiare per l'uso dell'IA. Non solo per prevenire abusi, ma anche per dimostrare ai dipendenti che l’organizzazione adotta l’IA in modo ponderato e responsabile, rafforzando la fiducia tra IT, compliance e utenti.

- Formazione: Al pari della configurazione tecnica, forma il personale su come usare efficacemente Copilot e su come comportarsi quando non è disponibile (es. "Se sei offline, ecco cosa Copilot può/non può fare...").

- Monitoraggio del ROI: Tieni traccia del tempo risparmiato o dei miglioramenti nella qualità del lavoro grazie a Copilot. Questo aiuterà a giustificare ulteriori investimenti, come l’acquisto di dispositivi Copilot+ o il finanziamento di iniziative AI on-premises.

Il panorama dell'IA aziendale sta evolvendo rapidamente. Microsoft Copilot, ad aprile 2025, è all'avanguardia nell'integrazione dell'IA generativa nel lavoro quotidiano. Anche se è nato fermamente nel cloud, è evidente che la visione di Microsoft per Copilot non si limita a scenari sempre connessi. Stiamo andando verso un mondo in cui i copiloti AI saranno onnipresenti – disponibili sulla scrivania, sul laptop su una cima montuosa o in un bunker senza collegamento esterno, lavorando al nostro fianco. Raggiungere questa ubiquità in modo responsabile sarà la prossima sfida. L'approccio ibrido di Microsoft indica che hanno compreso che un’unica soluzione (cloud) non può andare bene per tutti.

Per ora, la maggior parte delle organizzazioni sperimenterà Copilot come servizio cloud, ma è importante iniziare a gettare le basi (tecniche e di policy) per implementazioni più flessibili. Questi sforzi saranno premiati man mano che Microsoft rilascerà funzionalità sempre più adatte all'uso offline. Restando aggiornati sugli sviluppi di Copilot e collaborando con la roadmap di Microsoft, i professionisti IT potranno garantire di essere pronti a offrire i benefici di Copilot ai propri utenti – nel cloud, sull'edge, o ovunque nel mezzo.